提取转换负载(ETL)

回到术语表什么是ETL?

随着组织中数据量、数据源和数据类型的增长,在分析、数据科学和机器学习计划中使用这些数据以获得业务见解的重要性也在增长。优先考虑这些计划的需求给数据工程团队带来了越来越大的压力,因为在执行这些计划之前,将原始、混乱的数据处理成干净、新鲜、可靠的数据是关键的一步。ETL代表提取、转换和加载,它是工程师用于从不同来源提取数据的流程数据,将数据转换为可用和可信的资源,并将该数据加载到终端用户可以访问和使用的系统中,以便在下游解决业务问题。

ETL是如何工作的?

提取

此过程的第一步是从通常是异构的目标源(如业务系统、api、传感器数据、营销工具和事务数据库等)中提取数据。如您所见,其中一些数据类型可能是广泛使用的系统的结构化输出,而其他数据类型则是半结构化JSON服务器日志。有不同的方法来执行提取:- 部分提取——获取数据最简单的方法是如果源系统在记录被更改时通知您

- 部分提取(带有更新通知)——并非所有系统都能在发生更新时提供通知;但是,它们可以指向那些已更改的记录,并提供这些记录的摘要。

- 完全提取——有些系统根本无法识别哪些数据已被更改。在这种情况下,完全提取是从系统中提取数据的唯一可能。此方法要求拥有相同格式的最后一个提取的副本,以便您可以识别所做的更改。

变换

第二步包括将从源中提取的原始数据转换为不同应用程序可以使用的格式。在这个阶段,数据被清理、映射和转换,通常是到特定的模式,以满足操作需求。此过程需要进行几种类型的转换,以确保数据的质量和完整性。数据通常不会直接加载到目标数据源中,而是通常将其上传到登台数据库中。这一步确保在某些事情没有按计划进行的情况下可以快速回滚。在此阶段,您可以生成符合法规的审计报告,或者诊断和修复任何数据问题。负载

最后,load函数是将转换后的数据从暂存区写入目标数据库的过程,该数据库以前可能存在,也可能不存在。根据应用程序的需求,这个过程可能非常简单,也可能非常复杂。这些步骤中的每一步都可以使用ETL工具或自定义代码来完成。什么是ETL管道?

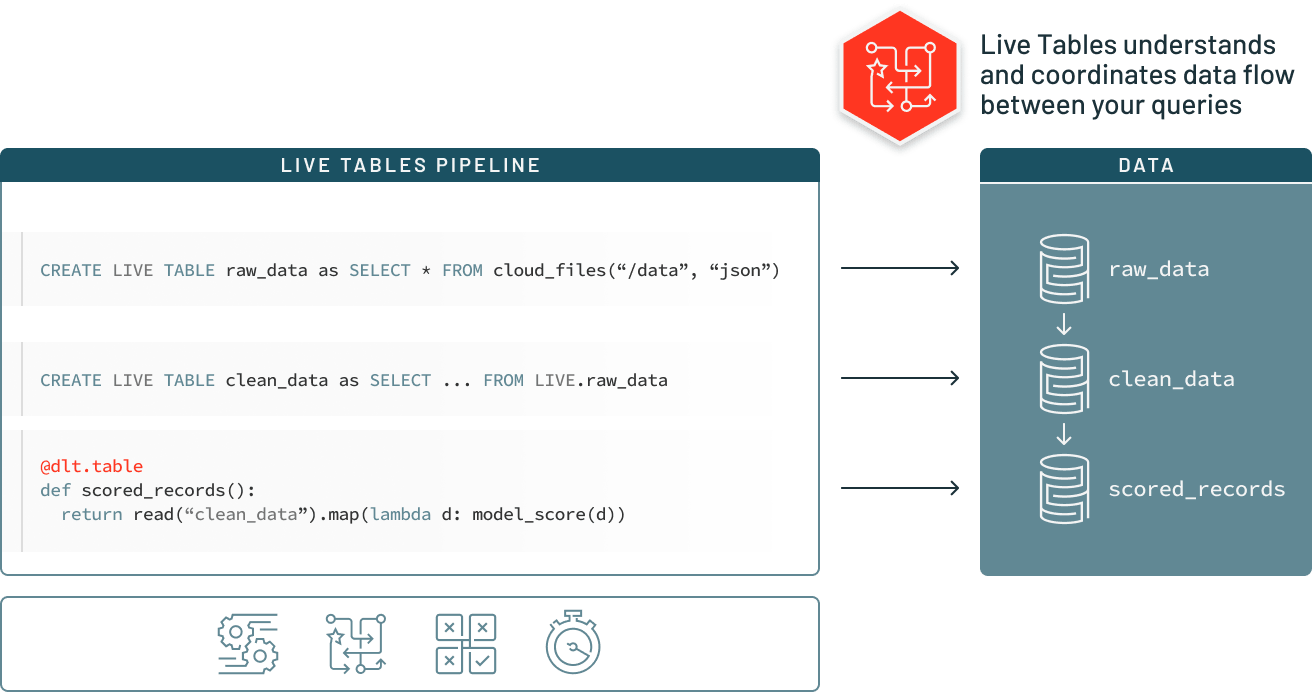

ETL管道(或数据管道)是ETL进程发生的机制。数据管道是一组工具和活动,用于将数据从一个具有数据存储和处理方法的系统移动到另一个可以以不同方式存储和管理数据的系统。此外,管道允许自动从许多不同的来源获取信息,然后将其转换和整合到一个高性能的数据存储中。ETL的挑战

虽然ETL是必不可少的,但随着数据源和类型的指数级增长,构建和维护可靠的数据管道已成为数据工程中更具挑战性的部分之一。从一开始,建立确保数据可靠性的管道是缓慢而困难的。数据管道是用复杂的代码和有限的可重用性构建的。在一个环境中构建的管道不能在另一个环境中使用,即使底层代码非常相似,这意味着数据工程师通常是瓶颈,每次都要重新发明轮子。除了管道开发之外,在日益复杂的管道体系结构中管理数据质量也很困难。不良数据经常被允许在管道中流动而不被发现,从而使整个数据集贬值。为了保持质量并确保可靠的见解,数据工程师需要编写大量的自定义代码,以在管道的每个步骤实现质量检查和验证。最后,随着管道规模和复杂性的增长,公司面临着管理它们的操作负载的增加,这使得数据可靠性难以维护。数据处理基础设施必须设置、扩展、重新启动、打补丁和更新——这意味着增加时间和成本。由于缺乏可见性和工具,管道故障很难识别,甚至更难解决。 Regardless of all of these challenges, reliable ETL is an absolutely critical process for any business that hopes to be insights-driven. Without ETL tools that maintain a standard of data reliability, teams across the business are required to blindly make decisions without reliable metrics or reports. To continue to scale, data engineers need tools to streamline and democratize ETL, making the ETL lifecycle easier, and enabling data teams to build and leverage their own data pipelines in order to get to insights faster.在三角洲湖上实现可靠的ETL自动化

Delta活动表(DLT)可以轻松地构建和管理可靠的数据管道,为Delta Lake提供高质量的数据。DLT通过声明式管道开发、自动测试以及监控和恢复的深度可见性,帮助数据工程团队简化ETL开发和管理。

额外的资源

回到术语表