宣布推出Delta Live表:使可靠的数据工程变得简单

[btn_cta caption="注册公开预览" url="//www.neidfyre.com/www/p/product-delta-live-tables" target="no" color="orange" margin="yes"]

随着组织中数据量、数据源和数据类型的增长,构建和维护可靠的数据管道已成为分析、数据科学和机器学习(ML)的关键推动因素。优先考虑这些计划会给数据工程团队带来越来越大的压力,因为在执行这些战略计划之前,将原始、混乱的数据处理成干净、新鲜、可靠的数据是关键的一步。

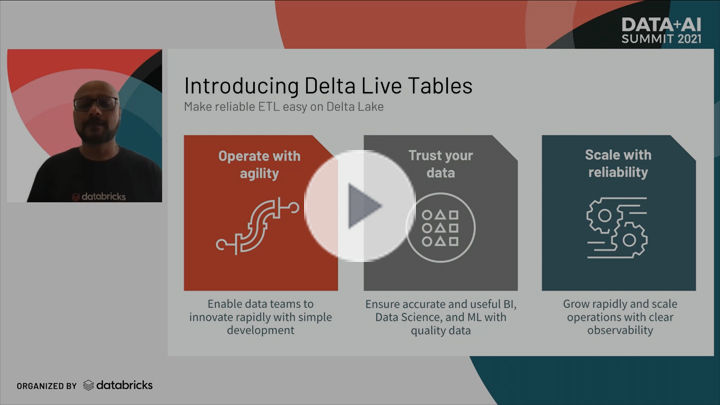

在数据+人工智能峰会,我们宣布Delta活动表(DLT), Delta Lake上的一种新功能,可为Databricks客户提供一流的体验,简化ETL开发和管理。DLT通过声明式管道开发、改进的数据可靠性和云规模的生产操作,极大地简化了数据工程师的工作。

我们开发这个产品是为了回应我们的客户,他们分享了他们在构建和维护可靠数据管道方面的挑战。那么,让我们来看看为什么ETL和构建数据管道如此困难。

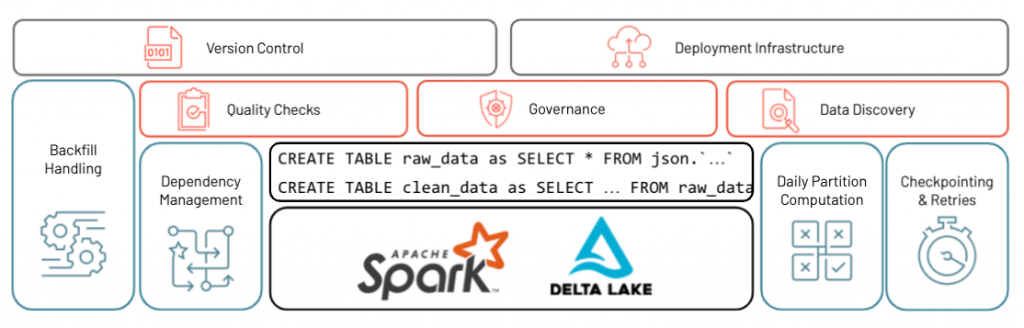

数据团队经常被要求定期提供关键数据以供分析。为了做到这一点,团队需要迅速将原始的、杂乱的输入文件转换成准确和最新的探索性数据分析仪表板。虽然编写SQL查询以加载数据并转换数据的初始步骤相当简单,但当这些分析项目需要始终如一的新数据,并且初始SQL查询需要转换为生产级ETL管道时,就会出现挑战。这些新数据依赖于来自其他各种来源的大量依赖关系,以及更新这些来源的作业。为了解决这个问题,许多数据工程团队将表分解为分区,并构建一个能够理解依赖关系并按正确顺序更新单个分区的引擎。

一旦构建完成,就需要检查点和重试,以确保能够从不可避免的瞬时故障中快速恢复。最重要的是,团队需要建立质量检查以确保数据质量,监控能力以警告错误,以及治理能力以跟踪数据如何在系统中移动。一旦所有这些都完成了,当新的请求到来时,这些团队需要一种方法来重做整个过程,并在此基础上添加一些更改或新功能。

由于所有这些团队的时间都花在了工具上,而不是转换上,操作复杂性开始占据主导地位,数据工程师能够花费越来越少的时间从数据中获得价值。

Delta活动表

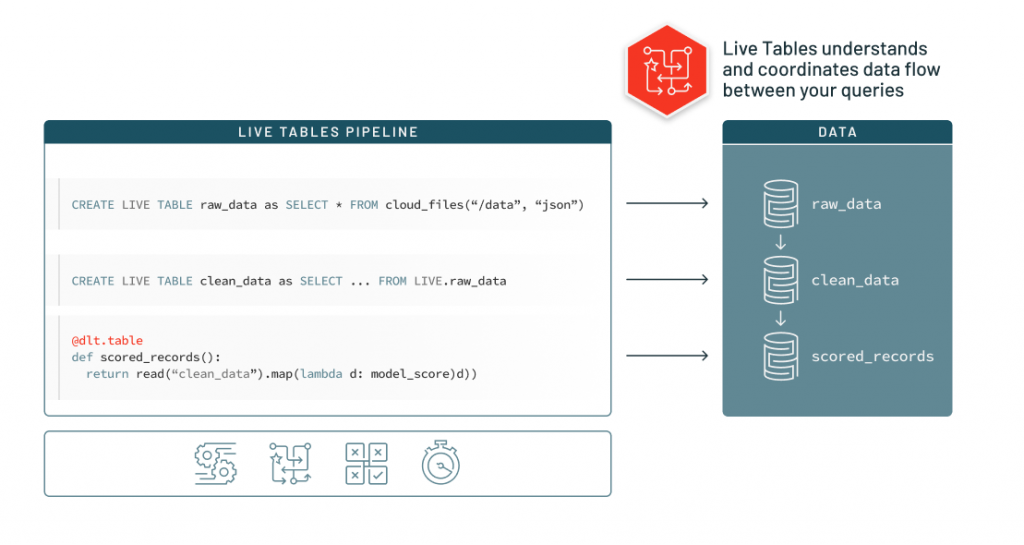

DLT使数据工程师能够简化和民主化ETL,使ETL生命周期更容易,并使数据团队能够通过构建只编写SQL查询的生产ETL管道来构建和利用他们自己的数据管道。通过在SQL查询中添加“LIVE”,DLT将开始自动处理您的所有操作、治理和质量挑战。通过将Python与SQL混合使用的能力,用户可以获得强大的SQL扩展,以实现高级转换,并将AI模型嵌入管道的一部分。

了解数据依赖关系

DLT接受您编写的用于转换数据的查询,而不仅仅是对数据库执行查询,DLT深入理解这些查询并分析它们以了解它们之间的数据流。一旦它理解了数据流,沿袭信息就会被捕获,并可用于保持数据新鲜和管道平稳运行。

这意味着,由于DLT理解数据流和沿袭,并且该沿袭是以与环境无关的方式表示的,因此数据的不同副本(即开发、生产、登台)是隔离的,并且可以使用单个代码库进行更新。同一组查询定义可以在任何这些数据集上运行。

跟踪数据谱系的能力对于改进变更管理和减少开发错误是非常有益的,但最重要的是,它为用户提供了用于分析的来源的可见性——增加了对来自数据的见解的信任和信心。

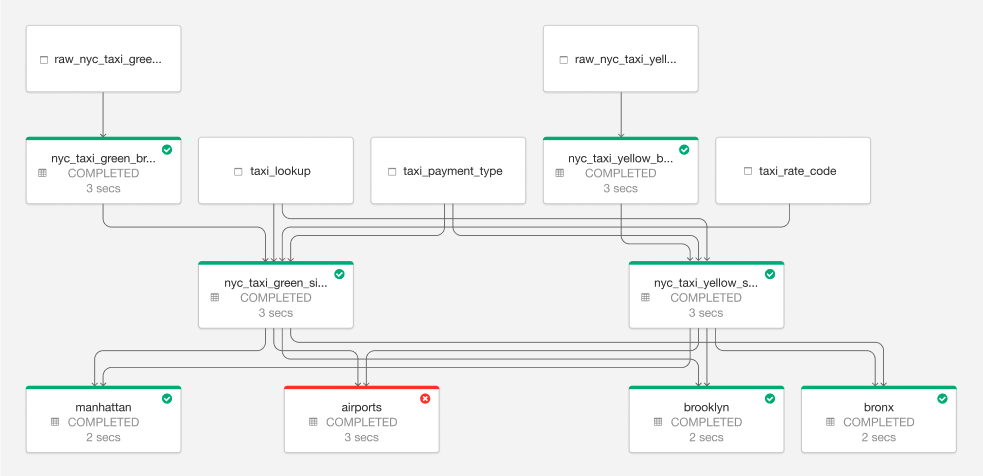

获得对管道的深入可见性

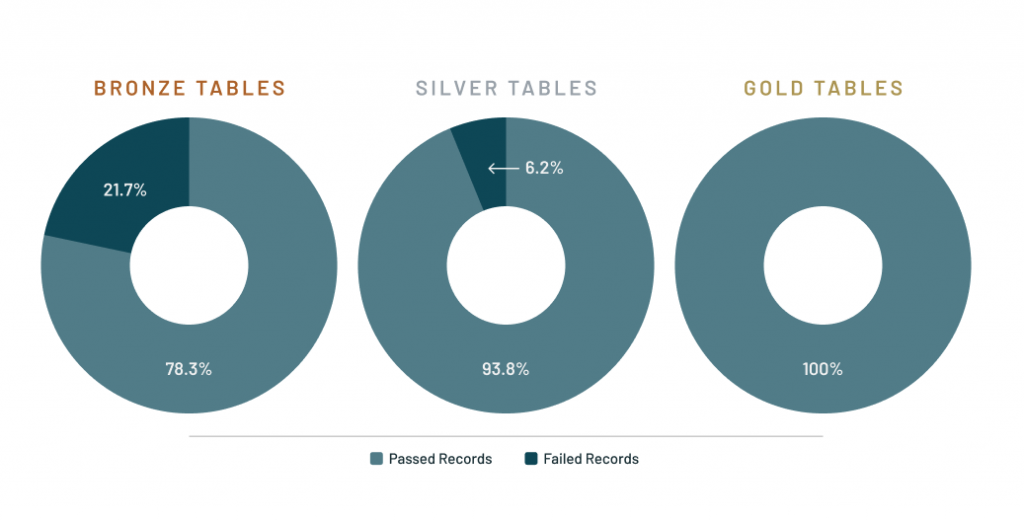

DLT通过详细的日志记录和工具,提供了对管道操作的深度可见性,以可视化地跟踪操作统计数据和质量指标。有了这个功能,数据团队可以了解管道中每个表的性能和状态。数据工程师可以看到哪些管道运行成功或失败,并可以通过自动错误处理和轻松刷新来减少停机时间。

将数据视为代码

在构建这个新产品时,我们考虑的核心思想之一是将数据视为代码,这个思想在今天的许多数据工程项目中都很流行。您的数据应该是业务中发生的事情的唯一真实来源。除了转换之外,还有许多东西应该包含在定义数据的代码中。

- 质量的期望:通过声明性的质量期望,DLT允许用户指定是什么导致坏数据是坏的,以及应该如何以可调的严重程度处理坏数据。

- 带有转换的文档: DLT使用户能够记录数据的来源、用途和转换方式。该文档与转换一起存储,确保该信息始终是最新的。

- 表属性:表的属性(例如,包含PII)以及关于表执行的质量和操作信息会自动捕获在事件日志中。此信息可用于了解数据如何流经组织并满足法规要求。

通过声明式管道开发、改进的数据可靠性和云规模的生产操作,DLT使ETL生命周期更容易,并使数据团队能够构建和利用他们自己的数据管道,以更快地获得洞察,最终减轻数据工程师的负担。

“在壳牌,我们将所有传感器数据聚合到一个集成数据存储中-以数万亿的记录规模工作。Delta Live Tables帮助我们的团队在管理这种规模的数据时节省了时间和精力。我们一直专注于不断提高我们的人工智能工程能力,并拥有一个具有图形界面的集成开发环境(IDE),支持我们的提取转换负载(ETL)工作。这种能力增强了现有的湖屋架构,Databricks正在颠覆ETL和数据仓库市场,这对像我们这样的公司很重要。我们很高兴能继续与Databricks作为创新合作伙伴合作。”

开始

Delta Live Tables目前处于封闭的公开预览中,并可根据客户要求提供。现有客户可以请求访问DLT,以开始开发DLT管道在这里.参观演示中心来看看DLT的演示和DLT文档了解更BOB低频彩多。

由于这是一个封闭的预览,我们将根据具体情况为客户提供服务,以确保预览过程顺利进行。我们的预览时间有限,希望能让尽可能多的客户参加。如果我们无法在门控预览期间登上您,当我们准备好广泛推出时,我们将联系并更新您。