是时候重新评估你与Hadoop的关系了

2021年3月25日 在数据+ AI博客

在过去的一年里,随着企业被迫适应远程、分布式的劳动力,云采用以前所未有的速度加速了14%,导致2020年比大流行前的预测高出2%或130亿美元——未来几年可能会有超过6000亿美元的本地到云迁移。这种向云的转变越来越重视新一代数据和分析平台,以推动创新和实现企业数字化转型战略。bob体育客户端下载然而,许多组织仍然为其遗留的复杂性、不可扩展的基础设施和严重的维护开销而挣扎Hadoop环境和最终牺牲他们的数据的价值,反过来,他们的竞争优势的风险。为了应对这一挑战,并在数据中释放更多(有时是隐藏的)机会,组织正在转向开放、简单和协作的基于云的数据和分析平台,如Databricks Lakehouse平台。bob体育客户端下载在本博客中,您将了解驱动组织探索现代云解决方案的挑战,以及湖屋架构在激发下一波数据驱动的创新中所扮演的角色。

Hadoop未兑现的承诺

Hadoop的分布式文件系统(HDFS)在推出时是一项改变游戏规则的技术,并将继续成为数据历史上的一个图标。由于它的出现,组织不再受关系数据库的限制,它产生了现代大数据存储和最终的云数据湖。所有的荣耀和喧嚣到2015年Hadoop努力支持所有数据类型的发展潜力——尤其是在企业规模上。最终,随着数据环境和随之而来的业务需求的发展,Hadoop难以继续兑现其承诺。因此,企业已经开始探索基于云计算的替代方案,从Hadoop迁移到云计算的速度只增不减。

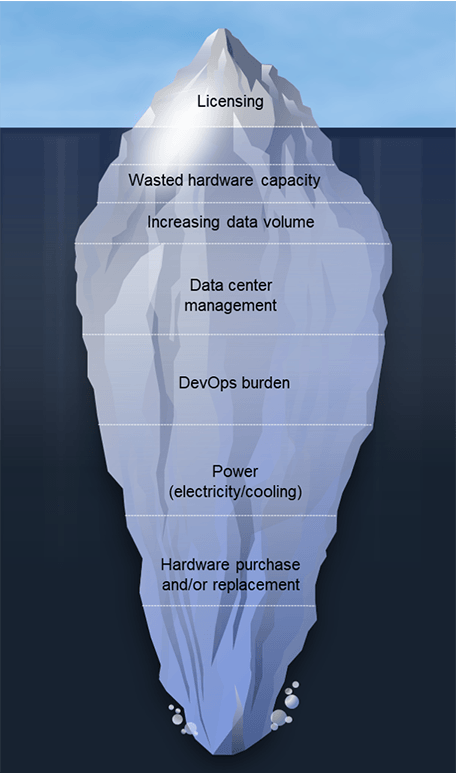

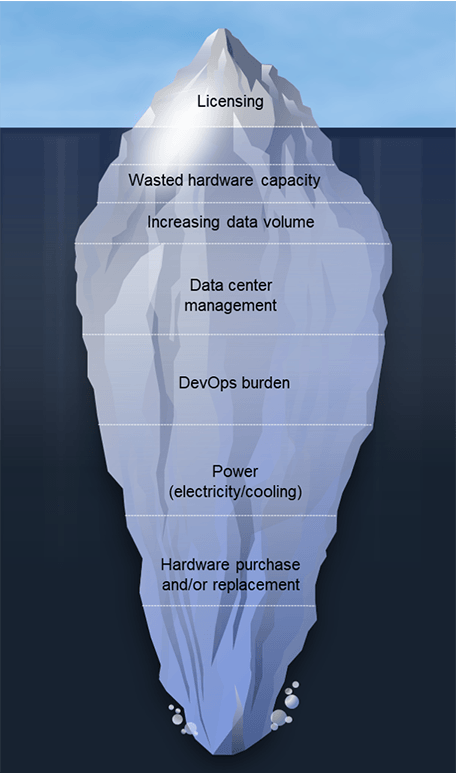

团队从Hadoop迁移的原因有很多;它通常是“推”和“拉”的组合。现有Hadoop系统的局限性以及高昂的许可和管理成本正促使团队探索替代方案。他们还被现代云数据架构带来的新可能性所吸引。虽然架构需求因组织而异,但我们看到几个共同的因素导致客户意识到是时候开始说了再见.这些包括:

- 硬件容量浪费:在内部部署实现中,容量过剩是必然的,因此您可以扩展到峰值时间需求,但结果是大部分容量处于空闲状态,但会继续增加操作和维护成本。

- 扩张成本迅速增加:在本地Hadoop环境中不可能解耦存储和计算,因此成本随着数据集的增加而增加。这与COVID-19大流行导致的快速数字化和全球增长率有关。研究表明,世界上创建、捕获、复制和消费的数据总量预计增长152.5%从2020年到2024年达到149泽字节。在一个超数据增长的世界里,失控的成本可能会迅速膨胀。

- DevOps的负担:根据我们客户的经验,每100个节点可以有4 ~ 8名全职员工。

- 电力成本增加:根据消耗和冷却,预计每年每台服务器的费用高达800美元。对于一个100个节点的Hadoop集群来说,这相当于每年8万美元!

- 新增和更换硬件的费用:这占TCO的20%,相当于Hadoop集群的管理成本。

- 软件版本升级:这些升级通常是强制执行的,以确保支持合同被保留,这些项目一次需要几个月的时间,提供的新功能很少,并且占用了数据团队宝贵的带宽。

除了上述所有挑战之外,人们还真正担心Hadoop的长期生存能力。2019年,世界看到了Hadoop领域的大规模瓦解。谷歌,2004年MapReduce论文支持创建Apache Hadoop,完全停止使用MapReduce,作为在推特上谷歌技术基础设施高级副总裁,Urs Hölzle。还有一些非常引人注目合并而且收购在Hadoop的世界里此外,在2020年,一家领先的Hadoop提供商将其产品集从以Hadoop为中心转移,因为Hadoop现在被认为是“与其说是一种技术,不如说是一种哲学”。最后,在2021年,Apache软件基金会宣布了Hadoop生态系统中十个项目的退役.这种日益增长的担忧与数字化的加速需求相结合,促使许多公司重新评估他们与Hadoop的关系。

向湖屋建筑的转变

湖屋架构是数据驱动组织的理想数据架构。它结合了数据仓库和数据湖的最佳品质,为所有数据工作负载提供单一的高性能解决方案。Lakehouse架构支持各种用例,例如流数据分析到BI、数据科学和AI。为什么客户喜欢Databricks Lakehouse平台?bob体育客户端下载

- 这很简单。将数据、分析和人工智能统一在一个平台上。bob体育客户端下载

- 它是开放的。使用开放标准和格式统一您的数据生态系统。

- 这是协作。统一数据团队,在整个数据和人工智能工作流程中进行协作。

与遗留的Hadoop环境相比,湖屋架构可以带来显著的收益,遗留的Hadoop环境“吸引”公司采用云计算。这也包括那些尝试在云中使用Hadoop,但没有得到与预期或期望相同结果的客户。Scribd的工程总监R. Tyler Croy解释道Databricks声称对大多数传统Apache Spark™工作负载的优化达到30%-50%。出于好奇,我重构了我的成本模型,以考虑Databricks的价格和潜在的Spark作业优化。在调整数字之后,我发现以17%的优化率,Databricks将大大降低我们的亚马逊网络服务(AWS)基础设施的成本,以至于它将支付Databricks平台本身的成本。bob体育客户端下载在我们最初的评估之后,我已经被Databricks提供的特性和开发人员速度的提高所说服。当我在我的模型中运行数字时,我知道我不能不采用Databricks!”

Scribd并不孤单;从Hadoop迁移到Databricks Lakehouse平台的其他客户包括:bob体育客户端下载

- H&M每天处理来自70多个市场的5000多家商店和数百万客户的海量数据。他们基于hadoop的架构给数据带来了挑战。它变得资源密集型和成本高昂,提出了数据安全问题,难以扩展业务以支持来自各种孤立数据源的数据科学工作,并且由于DevOps的严重延迟而减缓了上市时间。从构思到制作需要整整一年的时间。通过使用Databricks, H&M可以将运营成本降低70%,改善跨团队协作,并通过更快的洞察时间来提高业务影响,从而提高运营效率。

- Viacom18需要处理tb级的每日查看数据以优化编程。他们的本地Hadoop数据湖无法在sla中处理90天的滚动数据,限制了他们交付业务需求的能力。使用Databricks,尽管数据量增加,但查询时间更快,DevOps更少,大大降低了成本。Viacom18还通过一个全面管理的平台,大规模支持ETL、分析和ML,将团队工作效率提高了26%。bob体育客户端下载

- 利洁时集团(RB)在预测50万家门店需求的复杂过程中苦苦挣扎。他们每天通过250条管道处理超过2TB的数据。遗留的Hadoop基础设施被证明是复杂的、麻烦的、昂贵的扩展和挣扎的性能。通过Databricks, RB实现了10倍以上的容量来支持业务量,98%的数据压缩从80TB到2TB,降低了运营成本,并为24x7作业提供了2倍快的数据管道性能。

Hadoop从来就不是为在云环境中运行而构建的。虽然基于云的Hadoop服务与本地的Hadoop服务相比有了渐进式的改进,但与湖屋架构相比,两者仍然滞后。这两个Hadoop实例都产生了低性能、低生产力、高成本,并且无法大规模地处理更复杂的数据用例。

面向未来的数据、分析和人工智能驱动的增长

云迁移决策是业务决策。它们迫使公司认真审视当前系统交付的现实情况,并评估他们需要实现的近期和长期目标。随着人工智能投资继续获得动力,数据、分析和技术领导者需要在现有Hadoop架构之外的思考中发挥关键作用,思考“这将使我们达到我们需要去的地方吗?”

随着目标的清晰,关键的技术细节也随之出现,比如技术映射、评估云资源利用率和成本-性能比,以及构建一个最小化错误和风险的迁移项目。但最重要的是,您需要有数据驱动的信念,是时候重新评估您与Hadoop的关系了。BOB低频彩从Hadoop迁移如何在您的数据用例中加速业务成果。

1.资料来源:高德纳市场数据手册,高盛全球投资研究