宣布砖运行时机器学习

砖激动地宣布砖运行时机器学习,包括现成的机器学习框架,简化了分布式训练,GPU的支持。注册为我们即将到来的研讨会学习更多。BOB低频彩

今天比以往任何时候都更数据科学家和机器学习人员有机会将他们的业务通过实现复杂的推荐引擎模型,广告定位、语音识别、物体识别、机器人、情绪分析、预测分析等。

然而,从业者面临多重挑战实现这样的应用程序时:

- 环境配置:设置和维护复杂环境的能力由于多种机器学习框架可用。

- 分布式训练:能力训练模型在分布式时尚更快地得到结果。这需要专业技能和管理复杂的代码。

- 计算能力:能够运行在gpu并行工作负载最大的表演。这是深度学习应用程序所必需的。

在这篇文章中,我们将介绍如何砖可以帮助克服这些挑战。

介绍砖运行时机器学习

预先配置的机器学习框架,包括XGBoost、scikit-learn TensorFlow, Keras, Horovod等等。

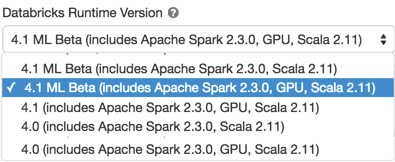

根据客户需求,我们兴奋地宣布新的本地和深度集成流行的机器学习框架的一部分砖运行时为毫升。新的运行时特性XGBoost、scikit-learn numpy以及流行的深度学习框架等TensorFlowKeras Horovod,和他们的依赖关系。

毫升的砖运行时是一个方便的方式开始新的一砖与所需的许多图书馆集群的分布式TensorFlow深度学习培训。此外,它确保兼容性的库包括(如TensorFlow和CUDA / cuDNN)之间,并大大降低了集群比使用init脚本启动时间。

简化分布式Horovod训练,TensorFlow和Apache火花

此外,我们很高兴地介绍HorovodEstimator旨在简化分布式深度学习。Horovod框架——最初引入的Uber -是一个流行的分布式框架培训Tensorflow, Keras, PyTorch。

HorovodEstimator是一个MLlib-style估计API利用Horovod和促进分布式,火花DataFrames multi-GPU训练的神经网络。它大大简化了ETL的集成与模型训练在TensorFlow火花,简化端到端从数据摄取工作流模型的训练。

下载这个笔记本今天开始。

最大计算功率与GPU的支持

所有这一切还是会影响有限,没有能力分布计算GPU加速的硬件上运行。

对于这些要求的工作负载,我们也扩大微软Azure GPU数控砖支持集群,NCv3, AWS P3 GPU系列。更详细的价格信息是可用的Azure砖也在AWS砖。

下一个步骤

内置机器学习框架和砖性能优越的运行时加上了基于gpu的并行计算能力,砖统一分析平台的独特服务的需要最先进的深度学习用例计算挑战。bob体育亚洲版bob体育客户端下载

今天开始在Databricks.com和注册为我们的独家网络研讨会,可伸缩的端到端深度学习在Apache火花和砖,6月27日上午10点PST更深的潜水和现场演示与专家苏安在香港和哈斯默奇,软件开发工程师在砖。

我们期待着见到你!