Hadoop集群

回到术语表什么是Hadoop集群?

ApacheHadoop是一个开源的bob下载地址、基于java的软件框架和并行数据处理引擎。它使大数据分析处理任务被分解成更小的任务,可以通过使用算法(如MapReduce算法),并将它们分布到Hadoop集群中。Hadoop集群是计算机(称为节点)的集合,这些计算机连接在一起,在大数据集上执行这些类型的并行计算。与其他计算机集群不同,Hadoop集群是专门为在分布式计算环境中存储和分析大量结构化和非结构化数据而设计的。进一步区分Hadoop生态系统有别于其他计算机集群的是它们独特的结构和架构。Hadoop集群由连接的主节点和从节点组成的网络组成,这些节点利用高可用性、低成本的商用硬件。线性缩放和快速添加或减去节点的容量需求的能力,使它们非常适合大数据分析数据集大小变化很大的作业。Hadoop集群架构

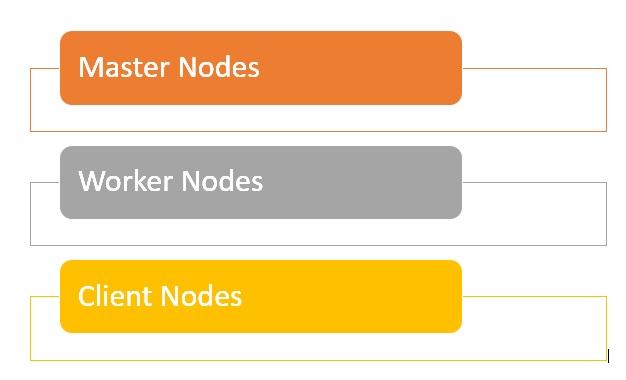

Hadoop集群由主节点和工作节点组成的网络组成,它们在Hadoop分布式文件系统中编排和执行各种作业。主节点通常使用更高质量的硬件,包括NameNode、Secondary NameNode和JobTracker,每个节点都运行在单独的机器上。worker由虚拟机组成,在商用硬件上运行DataNode和TaskTracker服务,并按照主节点的指示执行存储和处理作业的实际工作。系统的最后一部分是客户端节点,负责加载数据和获取结果。

- 主节点负责存储数据HDFS以及监督关键操作,比如使用MapReduce对数据进行并行计算。

- 工作节点由Hadoop集群中的大多数虚拟机组成,并执行存储数据和运行计算的工作。每个工作节点都运行DataNode和TaskTracker服务,用于接收来自主节点的指令。

- 客户端节点负责将数据加载到集群中。客户端节点首先提交描述如何处理数据的MapReduce作业,然后在处理完成后获取结果。

Hadoop中的集群大小是多少?

Hadoop集群大小是定义运行Hadoop工作负载的存储和计算能力的一组指标,即:- 节点数量:Master节点数量、Edge节点数量、Worker节点数量。

- 各类型节点配置:节点核数、RAM、Disk Volume。

Hadoop集群的优势是什么?

- Hadoop集群可以提高许多大数据分析工作的处理速度,因为它们能够将大型计算任务分解为可以以并行、分布式方式运行的小任务。

- Hadoop集群易于扩展,可以快速添加节点以提高吞吐量,并在面对不断增加的数据块时保持处理速度。

- 低成本、高可用性的商品硬件的使用使得Hadoop集群的设置和维护相对容易和便宜。

- Hadoop集群在分布式文件系统中复制数据集,使其对数据丢失和集群故障具有弹性。

- Hadoop集群使得集成和利用来自多个不同源系统和数据格式的数据成为可能。

- 出于评估目的,可以使用单节点安装部署Hadoop。

Hadoop集群的挑战是什么?

- 小文件的问题——Hadoop很难处理大量的小文件——默认情况下小于128MB或256MB的Hadoop块大小。它的设计初衷并不是为了以可伸缩的方式支持大数据。相反,Hadoop在只有少量大文件时工作得很好。最终,当您增加小文件的容量时,它会使Namenode重载,因为它为系统存储名称空间。

- 高处理开销——Hadoop中的读写操作可能很快就会变得非常昂贵,特别是在处理大量数据时。这一切都归结于Hadoop无法在内存中进行处理,而是从磁盘读取和写入数据。

- 只支持批处理——Hadoop是为批量处理小容量的大文件而构建的。这又回到了数据收集和存储的方式,所有这些都必须在处理开始之前完成。这最终意味着流数据不受支持,不能以低延迟进行实时处理。

- 迭代处理——Hadoop的数据流结构是在连续阶段建立的,这使得不可能进行迭代处理或用于ML。

额外的资源

回到术语表